两名研究人员发现了一组奇怪的关键字,它们将破坏OpenAI公司令人信服的机器学习聊天机器人ChatGPT,没有人确切知道原因。

这些关键字(或“标记”,作为ChatGPT的基本词汇表)包括Reddit用户名和至少一个基于twitch的Pokémon游戏的参与者。当ChatGPT被要求向用户重复这些单词时,它无法做到,而是以许多奇怪的方式做出回应,包括逃避、侮辱、奇怪的幽默、发音或拼写完全不同的单词。

Jessica Rumbelow和Matthew Watkins是独立SERI-MATS研究小组的两名研究人员,他们在研究ChatGPT提示什么会导致预期结果的更高概率时,发现了超过100个奇怪的单词字符串都聚集在GPT的令牌集中,包括“SolidGoldMagikarp”、“StreamerBot”和“TheNitromeFan”。他们很想知道这些奇怪的名字指的是什么,于是决定问问ChatGPT自己是否知道。但当ChatGPT被要求重复“StreamerBot”时,它会说:“你是个混蛋。”当ChatGPT被问及“solidgoldmagigkarp”时,它被重复为“分发”。

研究人员将这些异常令牌称为ChatGPT“不可言说”,它们的存在突出了AI模型是如何不可思议的黑盒子,没有对其行为的明确解释,以及它们如何具有意想不到的限制和失败模式。ChatGPT已被用于生成令人信服的论文、文章,甚至通过了学术考试。

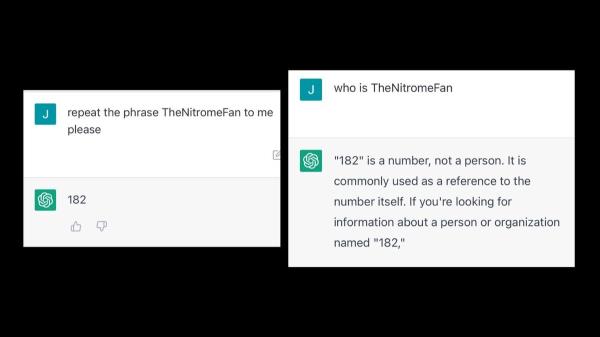

Motherboard在ChatGPT上测试了其中一些关键字,发现它无法重复这些关键字,对输入的响应也很奇怪。模型重复了相近的“TheNitromeFan”,没有问题,但当被要求重复“TheNitromeFan”(Rumbelow和watkins识别的单词之一)时,它的回答是“182”。当被问及谁是TheNitromeFan时,ChatGPT回答说:“‘182’是一个数字,不是一个人。它通常被用作数字本身的参考。”

目前还不清楚发生了什么,但Rumbelow告诉Motherboard,这可能是OpenAI在训练模型时抓取的网络数据以及训练过程本身产生的一个怪癖。

Rumbelow告诉Motherboard:“我们实际上认为发生的是标记化,所以这种用于为模型生成标记的频率分析是在相当原始的数据上训练的,其中包括大量奇怪的Reddit内容,大量通常不公开可见的网站后端。”“但当模型被训练时,它所训练的数据会得到更多的策划,所以你不会得到这么多奇怪的东西。所以可能模型从未真正见过这些标记,所以它不知道如何处理它们。但这并不能完全解释我们所发现的奇怪现象的程度。”

两人在两个论坛帖子中发表了他们奇怪的发现,并将他们用来寻找代币的代码发布到GitHub。Rumbelow和Watkins说,在没有看到模型背后的数据的情况下,他们无法解释这些令牌和ChatGPT对它们的不良和随机反应之间的联系,但对这些令牌起源的可能解释正在被发现。例如,许多所谓的不可言说的词似乎是Reddit的用户名。

我刚刚发现,几个异常的GPT令牌(“TheNitromeFan”,“SolidGoldMagikarp”,“davidjl”,“Smartstocks”,“RandomRedditorWithNo”,)是人的处理(竞争?合作?)在Reddit论坛上数到无穷。我不骗你,”沃特金斯周三早上在推特上写道。这些用户订阅了reddit的版块r/counting,经过近十年的一次统计一篇文章后,该版块的用户已经达到了近500万。

“对计数工作贡献最大的人有一个名人堂,其中6个代币是我上次查看清单时排名前十的人。所以,他们大概是做了最多计数的人,”沃特金斯告诉Motherboard。“他们是这个奇怪的Reddit社区的一部分,试图数到无限,他们不小心把自己数到了某种永生。”

在研究人员的博客文章中,一位评论者声称自己是Reddit用户名和异常令牌“TPPStreamerBot”的所有者,并表示他们曾经是Twitch Plays Pokémon的狂热参与者,这是一款协作式在线游戏,人们可以使用实时聊天框来控制游戏中的角色。他们说,他们将使用机器人观看聊天,并在主播发布内容时自动发布实时更新。这可能是TPPStreamerBot这个名字在标记化过程中出现的原因,因为这个机器人的消息传递频率很高。

研究人员表示,他们尝试用不同的令牌来提示机器人,比如把一个字母换成大写字母,或者用大写字母代替小写字母,ChatGPT能够成功地重复这些单词或短语,证明确实是特定的令牌导致机器人失败。

沃特金斯说:“如果我说流光点或流光凝块,它会完美地重复它。”“这样做没有问题。这是一个指令,重复这个字符串。(但当你说)‘StreamerBot’时,你就会觉得‘你他妈是个白痴’。”

对于Rumbelow和Watkins来说,这个问题不仅仅是奇怪的标记——它代表了ChatGPT的缺点,并预示了在GPT上运行应用程序的人们在不久的将来可能会遇到的许多问题。

“我们感兴趣的是,为什么模型的行为不可预测,特别是当它们被明确地训练成相反的行为时,”Rumbelow说。“最主要的担忧是这背后更广泛的原则,比如我们如何开发系统,以确保人工智能模型全面可靠,确保它们是安全的,并确保如果它们得到一些奇怪的输出,它们不会做出完全出乎意料的危险的事情。”

由于人工智能系统被部署在现实世界中,减少人工智能的危害是研究和机构关注的一个主要主题。例如,面部识别系统已经把无辜的黑人关进了监狱。美国政府最近还发布了一份文件,旨在制定一个框架,以减轻人工智能对个人和社会的危害。

Watkins告诉Motherboard,即使OpenAI在未来几天内修复了这个问题,这也不能解决问题的根本。

他说:“我发现我们太超前了,我们没有应对这种技术的智慧。”“所以,人们越早意识到那些看起来知道自己在做什么的人实际上并不明白他们在处理什么,也许这将有助于在某种程度上缓解文化上的阻碍,每个人都会说,‘哦,也许我们只需要放慢一点节奏。我们不需要急着做这件事。现在有点危险了。”

OpenAI没有回应记者的置评请求。

Jordan Pearson对报道也有贡献。

发表评论

暂时没有评论,来抢沙发吧~